Ilya认错,Scaling Law崩了?自曝SSI秘密技术路线取代OpenAI

Ilya认错,Scaling Law崩了?自曝SSI秘密技术路线取代OpenAIIlya终于承认,自己关于Scaling的说法错了!现在训练模型已经不是「越大越好」,而是找出Scaling的对象究竟应该是什么。他自曝,SSI在用全新方法扩展预训练。而各方巨头改变训练范式后,英伟达GPU的垄断地位或许也要打破了。

Ilya终于承认,自己关于Scaling的说法错了!现在训练模型已经不是「越大越好」,而是找出Scaling的对象究竟应该是什么。他自曝,SSI在用全新方法扩展预训练。而各方巨头改变训练范式后,英伟达GPU的垄断地位或许也要打破了。

半年两次大融资后,这家具身智能黑马再次获得融资!作为柏睿资本首次投资的具身智能企业,千寻智能不仅拥有出身自伯克利系联创,在技术、硬件、商业化上,也让人极有信心。

奥特曼在OpenAI伦敦开发者日上的最新采访,终于完整释出! 40分钟的采访过程中,奥特曼除了聊OpenAI未来模型发展方向、Agent、和最尊敬的竞争对手(就是此前碎片式走漏风声的几个问题)外,还就Scaling Law、半导体供应链、基础模型竞争成本、该雇佣什么年龄段的员工等十多个问题进行了快问快答。

2022年诞生的ChatGPT,已经在相当程度上实现了大模型的Scaling law(尺度定律)和通用能力涌现。

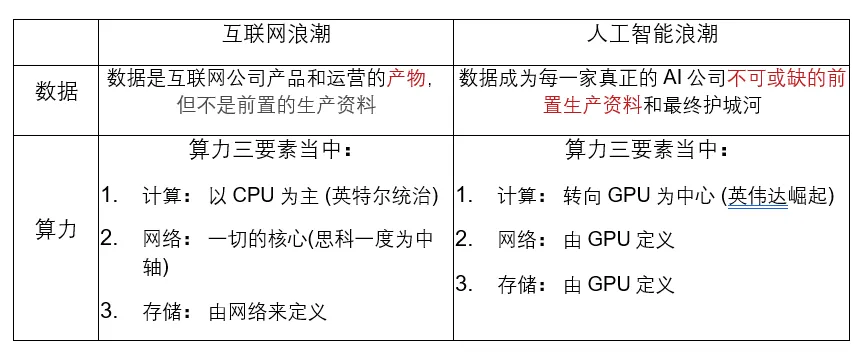

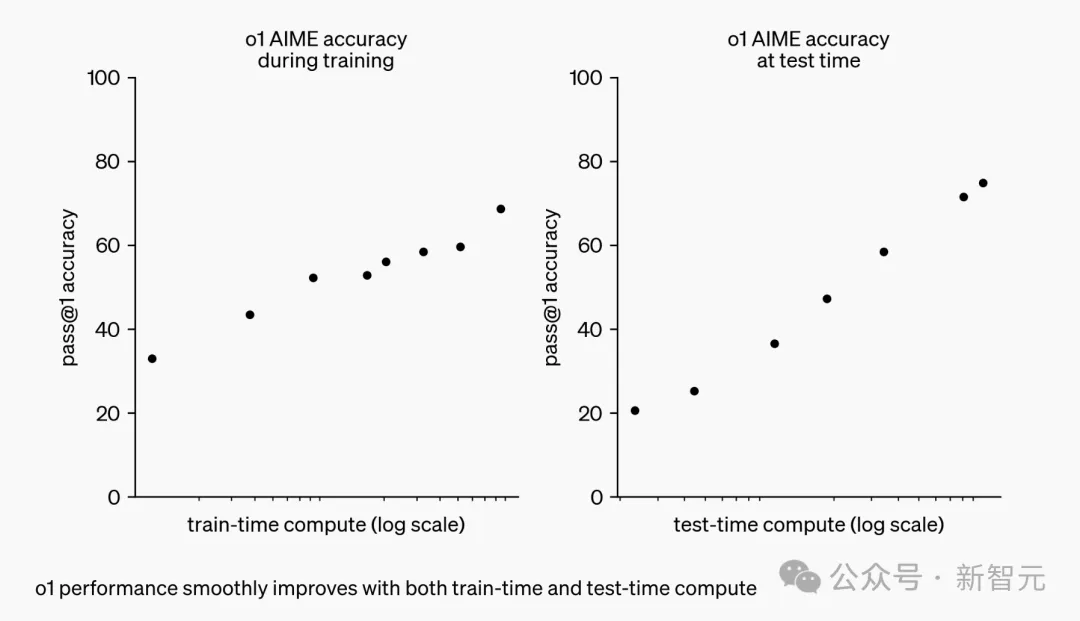

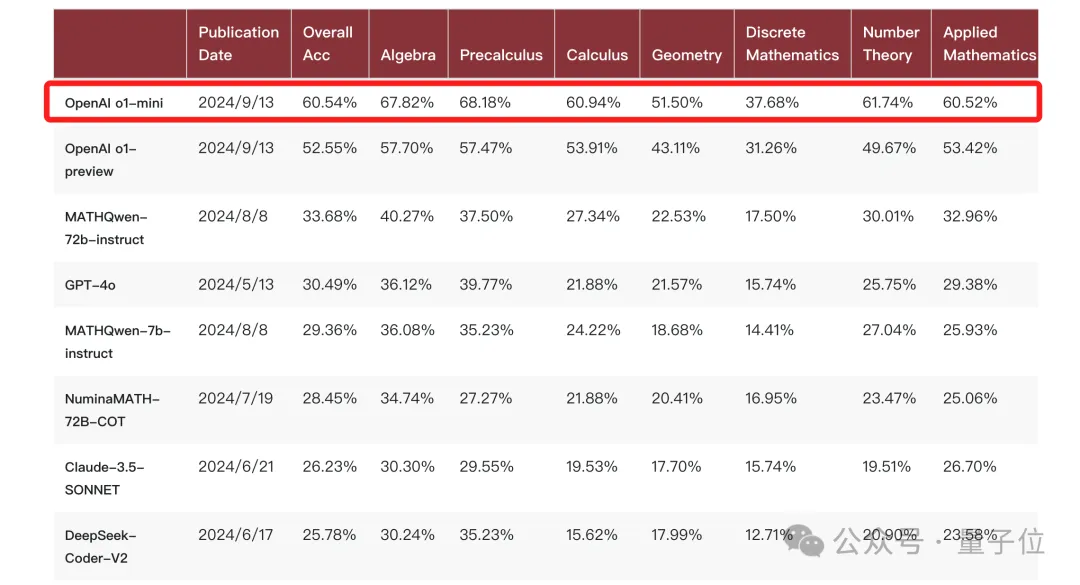

o1 作为 OpenAI 在推理领域的最新模型,大幅度提升了 GPT-4o 在推理任务上的表现,甚至超过了平均人类水平。o1 背后的技术到底是什么?OpenAI 技术报告中所强调的强化学习和推断阶段的 Scaling Law 如何实现?

本文是一篇发表在 NeurIPS 2024 上的论文,单位是香港大学、Sea AI Lab、Contextual AI 和俄亥俄州立大学。论文主要探讨了大型语言模型(LLMs)的词表大小对模型性能的影响。

Molmo,开源多模态模型正在发力!

CoT铸就了o1推理王者。 它开创了一种推理scaling新范式——随着算力增加、更长响应时间,o1性能也随之增长。

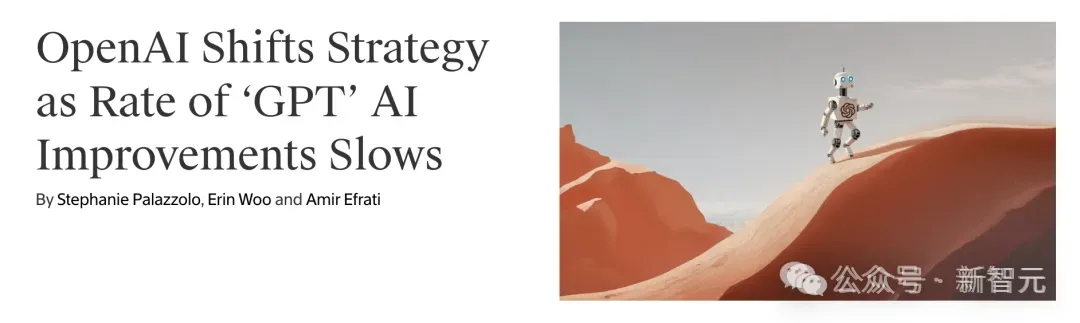

在电影《天下无贼》中,葛优扮演的黎叔有这样一句经典的台词,「二十一世纪什么最贵?人才!」而随着人工智能行业进入到大模型时代,这一问题的答案已然变成了「算力」。

OpenAI的新模型o1,可谓是开启了Scaling Law的新篇章——